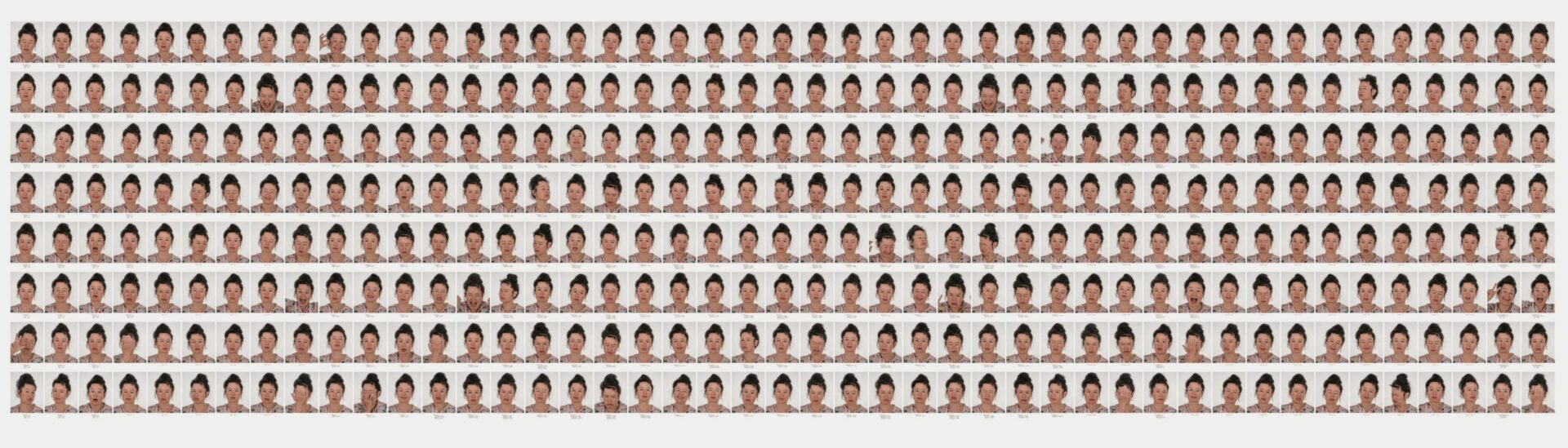

Photo : permission de | courtesy of the artist & Metro Pictures, New York

L’automatisation de l’empathie

La plupart des résultats algorithmiques retranscrits par Paglen sont douteux d’un point de vue ou d’un autre. Dans un cas, l’algorithme a déterminé que l’éventualité que Steyerl soit un homme était de 59,58 % et une femme, de 40,42 %. Pareille interprétation montre que ces algorithmes ne font que calculer des probabilités à partir de catégories rigides, alors qu’une bonne part de la recherche sur le genre évoque le caractère fluide de celui-ci, ce qui contredit certainement l’existence d’un lien définitif entre l’expression faciale et le sexe d’une personne. Sur d’autres photos, l’algorithme a classé dans des catégories entièrement distinctes des expressions que l’œil humain aurait perçues comme traduisant des émotions similaires. Il a déterminé, par exemple, que le fait de rouler les yeux vers l’arrière dénote chez Steyerl un état situé quelque part entre la « neutralité » et la « tristesse ». Le point à retenir, cependant, n’est pas que ces jugements sont erronés en apparence. Ce que cherche plutôt à montrer Paglen, c’est que les manières de « voir » des systèmes computationnels diffèrent complètement de celles des êtres humains. Chacune des images de Machine Readable Hito constitue effectivement une double représentation. La première est l’image visuelle d’un visage que la capacité de vision propre aux êtres humains permet d’analyser et d’interpréter ; la deuxième, une évocation (oblique, indirecte, par le biais du texte) de ce que voit un ordinateur lorsqu’il traite une image numérique. C’est cette seconde série de représentations qui nous intéresse ici, à cause de l’objectivité présumée qui l’imprègne, même si les jugements auxquels parviennent les logiciels d’intelligence artificielle contredisent cette assertion.

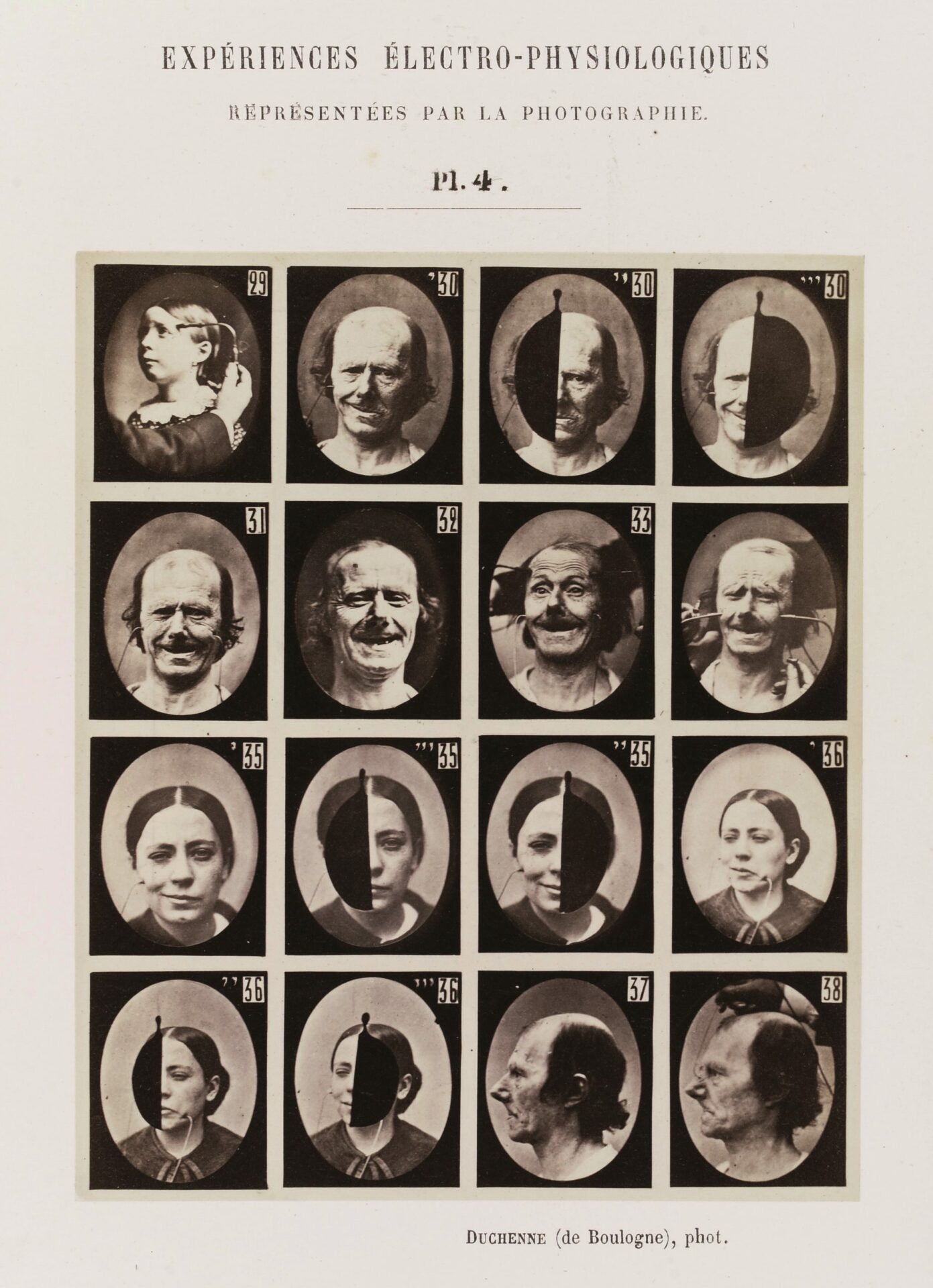

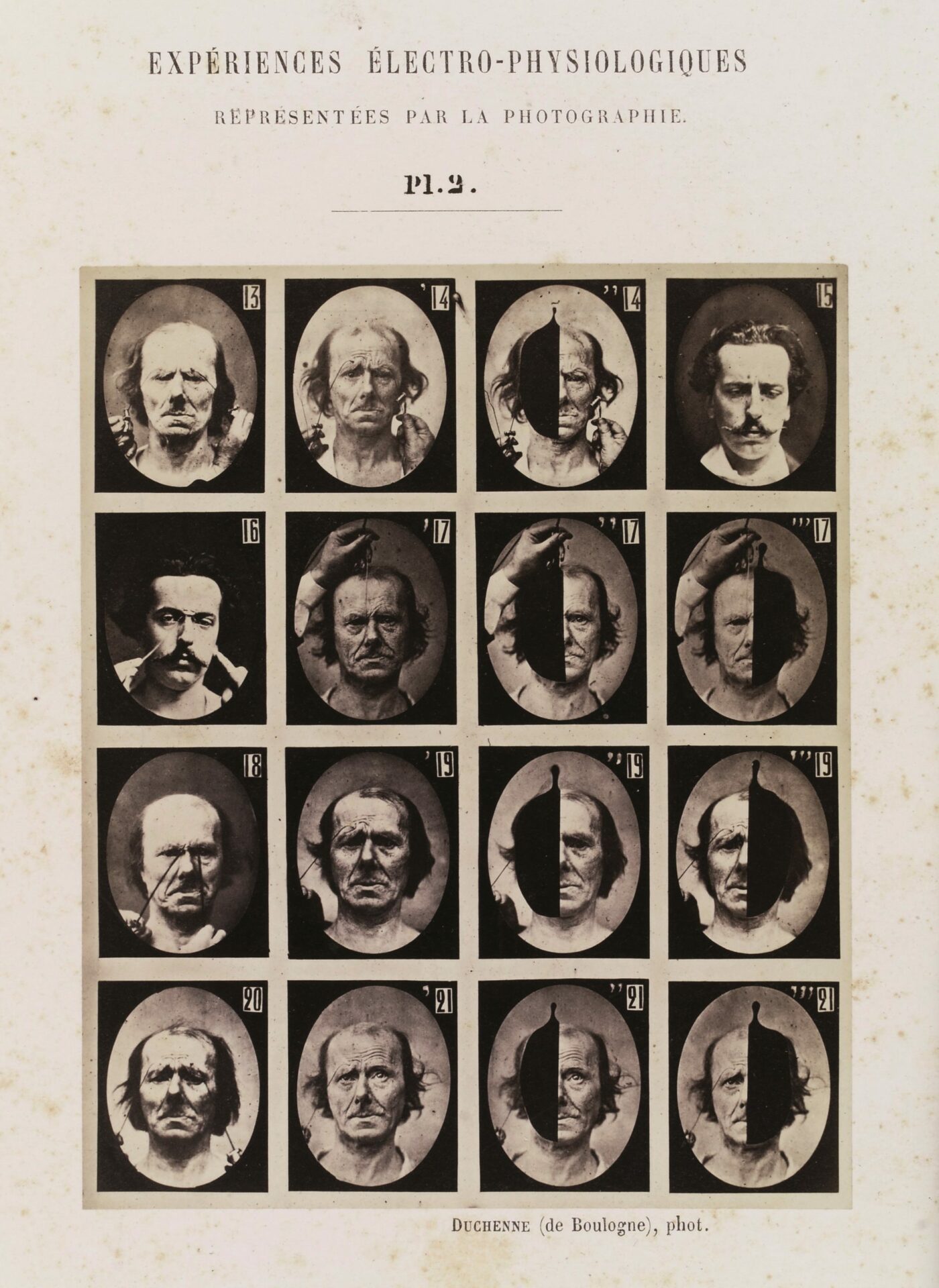

Experiments in physiology. Facial expressions.

Photos : Wellcome Collection

On ne peut pas contester ces systèmes technologiques en se limitant à signaler leurs erreurs d’interprétation. « Le monde invisible des images, avance Paglen, ne se résume pas à une taxonomie alternative du visuel. Procédant d’un exercice du pouvoir délibéré et trompeur, il convient parfaitement aux opérations moléculaires des dispositifs de surveillance policière et de surveillance des marchés – tout en étant conçu pour étendre ses vrilles dans les moindres replis de notre existence quotidienne.1 1 - Trevor Paglen, « Invisible Images (Your Pictures Are Looking at You) », The New Inquiry, 8 décembre 2016, <https://thenewinquiry.com/invisible-images-your-pictures-are-looking-at-you/. [Trad. libre] » Le fait que les algorithmes ne classent pas les visages avec exactitude (du moins du point de vue de la perception humaine) ne change pas grand-chose à l’usage qu’en font les monopoles des médias sociaux, les gouvernements et les corps policiers au service d’une perpétuation impersonnelle et automatique de la discrimination intégrée dans la technologie2 2 - afiya Umoja Noble, Algorithms of Oppression: How Search Engines Reinforce Racism, New York, New York University Press, 2018.. Les systèmes de vision machine ont pour tâche de produire une vérité objective, comme si leur indifférence et leur différenciation par rapport à la perception humaine rendaient effective leur objectivité3 3 - Cette idée est développée plus avant dans mon livre intitulé Inhuman Networks: Social Media and the Archaeology of Connection, New York, Bloomsbury, 2016..

Paglen s’intéresse en particulier à l’armée et à la police ainsi qu’à la séparation qui s’est opérée entre la culture visuelle des médias numériques, si abondamment utilisée par ces organes de contrôle, et les systèmes visuels humains – une préoccupation semblable à celles d’autres artistes comme James Bridle, Adam Harvey, Zach Blas et Steyerl elle-même. Par ailleurs, les technologies de reconnaissance des émotions auxquelles Paglen a eu recours dans Machine Readable Hito nous laissent entrevoir que la surveillance est liée à un élément qui ne semble avoir aucun rapport avec la politique du contrôle étatique : la psychologie de l’empathie. J’aimerais insister ici sur ce rapport entre automatisation de la vision et empathie, ce qui m’amène à revenir sur l’histoire de l’étude des expressions faciales en psychologie et son rôle dans la recherche actuelle sur l’empathie.

Si l’œuvre de Paglen fait allusion au régime visuel défini par les algorithmes et à son lien avec la surveillance, elle montre aussi – à une époque où l’empathie semble traverser une crise – que les systèmes computationnels, lorsqu’ils chevauchent le contrôle policier, peuvent également servir à moduler et à manipuler les possibilités de compréhension empathique.

Presque toutes les émotions reconnues par les algorithmes de vision machine sont issues des travaux réalisés par les psychologues Paul Ekman et Wallace Friesen, plus précisément de leur méthode appelée Facial Action Coding System (système de codage des mouvements faciaux). Connue sous l’acronyme FACS, cette méthode classifie en « unités d’action » les mouvements des muscles du visage. À chaque expression faciale correspond ainsi une combinaison précise d’unités d’action permettant de déterminer, par exemple, ce qu’une personne ressent ou si elle ment. La méthode FACS sert depuis longtemps de fondement aux technologies de reconnaissance des émotions4 4 - Kelly A. Gates, Our Biometric Future: Facial Recognition Technology and the Culture of Surveillance, New York, New York University Press, 2011. ; elle a joué un rôle essentiel dans la perpétuation d’un modèle douteux censé répertorier une gamme d’émotions universelles qui se manifesteraient de la même façon sur le visage de tous les membres de l’espèce humaine et dont l’interprétation serait univoque5 5 - Pour une critique détaillée de ce modèle de l’émotion, voir Ruth Leys, The Ascent of Affect: Genealogy and Critique, Chicago, University of Chicago Press, 2017.. Ces émotions sont habituellement la colère, le dégout, la peur, la joie, la tristesse et la surprise ; elles correspondent incidemment à celles que répertorient les systèmes comme celui de Microsoft, fait qui s’explique par le lien qui unit les logiciels de reconnaissance et de représentation des émotions faciales.

Les catégories d’émotions reconnues par la méthode FACS – dont le résultat de l’algorithme figure sous les images de Hito Steyerl – remontent à un manuel de Robert S. Woodworth intitulé Experimental Psychology, paru en 1938. Ce psychologue, ayant passé en revue un certain nombre d’études sur les expressions faciales, avait répété ces études de manière à obtenir des résultats reproduisibles. Pour y parvenir, il a dû réduire toutes les expressions faciales à six catégories se rapportant en apparence à des expériences très différentes : l’amour (incluant le bonheur et la joie) ; la surprise ; la crainte (incluant la souffrance) ; la colère (incluant la détermination) ; le dégout ; et le mépris. S’il a choisi ces catégories, c’est d’abord et surtout parce qu’elles permettaient de satisfaire au critère de reproduisibilité précité6 6 - Mes commentaires se fondent sur la version révisée du manuel que Robert S. Woodworth a publiée en collaboration avec Harold Schlosberg : Experimental Psychology (édition revue), Londres, Methuen & Co. Ltd., 1954, p. 112-119..

À l’époque, les psychologues tels que Woodworth s’intéressaient principalement à la capacité d’un observateur de juger correctement des émotions qui lui étaient présentées. Ils s’appuyaient sur certaines thèses de Charles Darwin (qui s’était lui-même inspiré des photographies de Duchenne de Boulogne) selon lesquelles les expressions faciales sont des mécanismes évolutionnaires permettant de comprendre l’expérience d’autrui à partir de l’apparence7 7 - Charles Darwin, The Expression of the Emotions in Man and Animals, New York, D. Appleton and Company, 1897.. Ces psychologues de l’école américaine cherchaient à déterminer si les sujets arriveraient à reconnaitre avec exactitude les émotions communiquées par des expressions faciales particulières. Pour mener leurs expériences, ils avaient recours à des séries d’images (provenant d’Allemagne pour la plupart) avec lesquelles les artistes s’entrainaient à représenter avec justesse les passions exprimées par le visage humain.

Machine Readable Hito, 2017.

Photo : permission de | courtesy of the artist & Metro Pictures, New York

En réalité, les participants s’entendaient rarement sur l’interprétation à donner aux émotions représentées sur les photographies. On a toutefois supposé chaque fois que cette incapacité à se mettre d’accord était un problème attribuable aux observateurs plutôt qu’aux photographies comme telles ou à la simulation des émotions dans celles-ci. Ce jugement reflète d’ailleurs une conception, apparue au tournant du 20e siècle, voulant que la photographie constitue en soi une preuve8 8 - Joel Snyder, « Res Ipsa Loquitur », dans Lorraine Daston (dir.), Things That Talk: Object Lessons from Art and Science, New York, Zone Books, 2008, p. 195-221.. Or les désaccords entre observateurs ont persisté jusqu’à ce qu’on restreigne le choix de réponses à la classification proposée par Woodworth dans Experimental Psychology. Ce problème du jugement subjectif, l’analyse computationnelle des expressions faciales a contribué à le réduire encore davantage. Comme le suggère Paglen, ce sont les classifications algorithmiques reproduites dans Machine Readable Hito, plutôt que les images visuelles, qui possèderaient la force de l’objectivité.

La psychologie des émotions découle d’un usage particulier de la photographie qui laisse entendre que le fait de définir des catégories pour classer des photos aiderait à prouver que l’interprétation visuelle d’un visage donne accès à l’état émotionnel d’autrui. Voilà peut-être une façon de définir l’empathie, qui n’était pas à l’origine un construit psychologique. Emprunté à la théorie esthétique allemande du tournant du 20e siècle, ce concept dérive de l’Einfühlung, terme décrivant l’effet miroir ou le « ressenti de l’intérieur » qu’éprouve un sujet lorsqu’il contemple une œuvre d’art qui le touche particulièrement – ou qu’il observe un autre être humain. De plus en plus associée à l’empathie au sens psychologique du terme, l’Einfühlung a fini par être appliquée à toutes les relations humaines, même si, jusqu’à la fin des années 1970, cette notion était souvent boudée en partie à cause des débats qu’elle suscitait dans le domaine de la psychologie, de la philosophie et de l’esthétique autour de l’opposition entre le « ressenti » naturaliste et l’aliénation moderniste9 9 - Grant Bollmer, « Gaming Formalism and the Aesthetics of Empathy », Leonardo Electronic Almanac (à paraitre).. Bien qu’il soit difficile d’en traiter adéquatement en raison des définitions variées et nuancées qu’on lui prête, la notion d’empathie sert depuis les années 1970 à décrire un ensemble de troubles psychologiques caractérisés par une incapacité à faire correspondre une expression faciale à un état affectif particulier, incapacité attribuable à l’absence des moyens neurologiques pour le faire. On pense notamment que l’autisme, la psychopathie et le trouble de la personnalité limite (les trois principaux états psychologiques définis de cette façon) découleraient d’une perturbation de la capacité d’observer une expression faciale et de l’associer à un « connu » ou à un ressenti de l’intérieur10 10 - Grant Bollmer, « Pathologies of Affect: The “New Wounded” and the Politics of Ontology », Cultural Studies, vol. 28, nº 2 (2014), p. 298-326.. D’autres avancent qu’il y aurait un lien entre l’empathie et l’existence de « neurones miroirs » qui permettraient au cerveau de restituer l’état émotionnel d’autrui ; toutefois, leur présence dans le cerveau humain n’a pas été démontrée, même si elle a été observée chez les macaques. Quoi qu’il en soit, l’empathie renvoie à la faculté de se mettre à la place d’autrui, à un effet miroir psychologique qui se traduit avant tout par l’aptitude à lire les expressions sur le visage d’un autre être humain.

Machine Readable Hito illustre l’influence qu’exercent l’histoire de la psychologie et ses hypothèses concernant la vision, les émotions et la relation empathique sur la culture visuelle des médias numériques – laquelle est sujette, comme toute autre forme de surveillance, aux mécanismes automatisés des ordinateurs. Sans qu’il soit nécessaire de trancher le vaste débat autour des catégories fondamentales de l’émotion et de l’empathie telles que les a opérationnalisées la psychologie, les œuvres comme celle de Paglen nous invitent à mettre en doute l’« objectivité » et la « rationalité » des taxonomies appliquées aux relations humaines, leur intégration aux médias numériques et leur automatisation. Elles nous amènent aussi à nous questionner sur l’usage que feront de l’informatisation des émotions et de l’empathie la police, l’armée et les monopoles des médias sociaux, outre dans l’exercice d’un pouvoir de coercition. En effet, tous ces acteurs recourent à la vision machine pour extraire de l’information à partir d’images du visage, automatisant par le fait même une certaine connaissance de l’effet miroir, des émotions et de l’empathie dans la culture numérique. Cette évolution nous oriente vers un retour de l’utilisation de la phrénologie et de la physiognomonie à des fins de contrôle au moyen de la « modulation des affects11 11 - Mark Andrejevic, Infoglut: How Too Much Information Is Changing the Way We Think and Know, New York, Routledge, 2013, p. 52-54 et p. 77-110. [Trad. libre] ». Machine Readable Hito nous enseigne surtout ceci : les moyens technologiques déployés pour susciter l’empathie n’ont peut-être pas grand-chose à voir, en définitive, avec l’expérience et la perception humaines, car ils tendent à s’appuyer sur des systèmes algorithmiques de reconnaissance des émotions ; ils procèderaient plutôt d’un système rationalisé d’organisation rigide de la connaissance visuelle.

Traduit de l’anglais par Margot Lacroix